L’HDR sulle TV aiuta a visualizzare immagini qualitativamente migliori, con maggiori dettagli in zone molto buie o molto luminose. Qui spieghiamo cos’è l’HDR, come funziona e quanti standard ci sono.

Oggi sembra diventato difficilissimo scegliere quale TV acquistare. I produttori sono tanti, così come le sigle: dalla risoluzione (Full-HD, UHD, 4K, 8K) alla tipologia di pannello (LED, OLED, QLED, MiniLED), dai sistemi operativi fino alle tecnologie di visualizzazione dell’immagine come l’HDR. In questo articolo, cercheremo di fare chiarezza spiegando in termini semplici cos’è l’HDR e come funziona.

Cosa significa HDR?

HDR sta per High Dynamic Range che tradotto vuol dire “elevata gamma dinamica”. Ed è una tecnologia che permette ai TV moderni di mostrare con maggiore dettaglio immagini molto luminose o molto buie aumentando il contrasto. Di fatto, è una tecnologia che cerca di imitare l’esperienza di visualizzazione dell’occhio umano.

L’obiettivo, infatti, è quello di offrire un’immagine quanto più naturale e realistica possibile gestendo le informazioni di ogni singolo pixel.

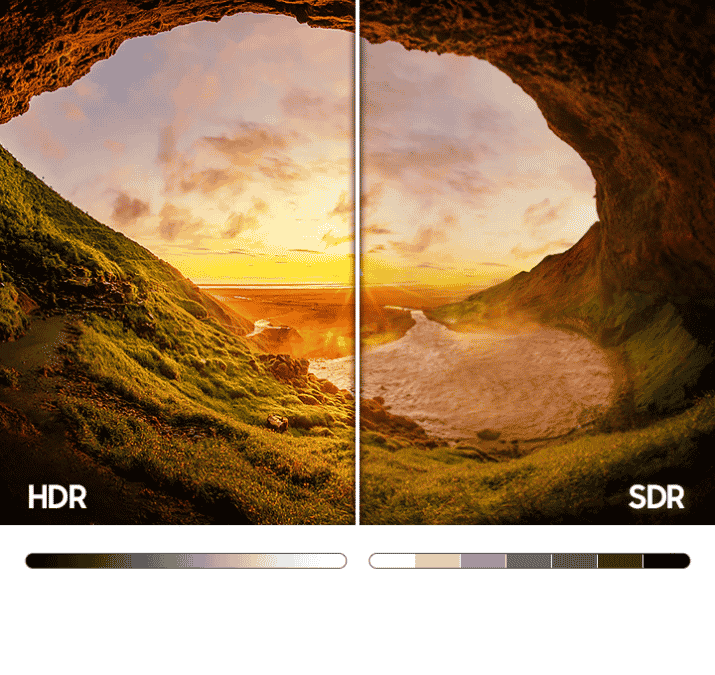

Immagina di guardare all’interno di una grotta buia. Il tuo occhio naturale non visualizzerà solamente uno sfondo nero ma riuscirà a scorgere il colore delle pareti della grotta. Bene, un TV HDR che mostra un contenuto HDR renderà visibili questi dettagli a differenza di un vecchio TV che non supporta la tecnologia HDR. Lo stesso risultato si ottiene con scene molto luminose.

Come funziona l’HDR?

Per visualizzare correttamente un video HDR è necessario che la fonte (il video) metta a disposizione dei metadati per la corretta visualizzazione che devono essere interpretati dalla sorgente (la TV). Sia la fonte che la sorgente devono supportare la tecnologia HDR. Per fortuna oggi proliferano anche i contenuti HDR come, ad esempio, quelli di Amazon Prime Video e Netflix.

Come abbiamo detto, l’obiettivo è di quello di offrire immagini quanto più possibili vicine alla realtà. Per farlo, i TV fanno affidamento su una serie di tecnologie con pannelli a 10 o 12 bit, tecnologia LED e nuovi driver riuscendo oggi a riprodurre una gamma colori molto più ampia rispetto al passato. Attualmente un TV HDR può visualizzare dal 50 al 75% dei colori percepiti dall’occhio umano contro il circa 35% del passato.

L’HDR, infatti, non serve solamente a rendere meglio le scene molto luminose o molto buie ma anche a riprodurre un maggior numero di colori.

Bisognerebbe mettere un TV accanto all’altro per apprezzare davvero le differenze tra la visualizzazione HDR e la precedente visualizzazione SDR (standard dinamic range), ma l’immagine qui sopra rende bene l’idea.

I diversi standard HDR

A complicare la situazione ci hanno pensato i produttori di TV e contenuti che hanno dato vita a diversi standard per la tecnologia HDR:

- HDR10

- HDR10+

- Dolby Vision

- HLG

L’obiettivo è comune ma sono basati su algoritmi differenti per la realizzazione dei contenuti e purtroppo non sono compatibili tra di loro. Un TV HDR10, ad esempio, non sfrutterà completamente la qualità offerta da un contenuto Dolby Vision.

- HDR10 è il più diffuso, è open source e si basa su metadati statici che calibrano la luminosità basandosi sulla scena più luminosa

- HDR10+ è la sua evoluzione e la differenza sta nell’utilizzo di metadati dinamici applicando le impostazioni sulla base delle caratteristiche di ogni singola scena, non solo della più luminosa. I metadati sono informazioni aggiuntive (come luminosità e colore) sulle immagini utilizzate.

- Dolby Vision è come HDR10+, ma è uno standard proprietario sviluppato da Dolby a cui i produttori devono pagare una royalty per essere certificati.

- HLG (Hybrid Log-Gamma) è stato sviluppato per le trasmissioni live televisive da BBC e NHK (servizio pubblico radiotelevisivo giapponese) che combina la gamma dinamica standard (SDR) e l’HDR in un unico segnale video. È compatibile anche con schermi non HDR.